Nvidia lance TensorRT-LLM pour Windows et Stable Diffusion, accélérant les LLM et les outils associés

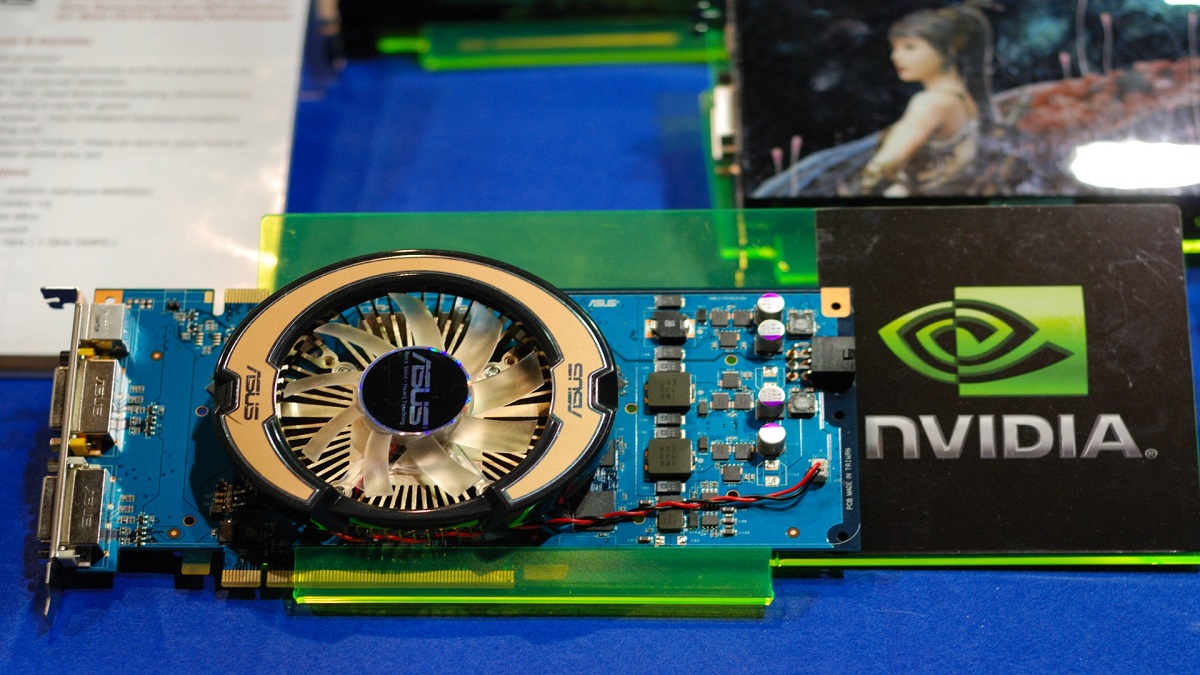

Nvidia a annoncé qu’il ajoutait la prise en charge de son SDK TensorRT-LLM à Windows et à des modèles tels que Stable Diffusion, dans le but de rendre les grands modèles de langage (LLM) et les outils associés plus rapides. TensorRT accélère l’inférence, le processus de traitement des informations pré-entraînées et de calcul des probabilités pour obtenir un résultat, comme une image de diffusion stable nouvellement générée. Avec ce logiciel, Nvidia souhaite jouer un rôle plus important dans ce domaine de l’IA générative.

Nvidia lance TensorRT-LLM pour Windows et Stable Diffusion

TensorRT-LLM décompose les LLM comme Llama 2 de Meta et d’autres modèles d’IA comme Stable Diffusion de Stability AI pour leur permettre de fonctionner plus rapidement sur les GPU H100 de Nvidia. La société a déclaré qu’en exécutant les LLM via TensorRT-LLM, « cette accélération améliore considérablement l’expérience pour une utilisation plus sophistiquée du LLM, comme les assistants d’écriture et de codage ».

De cette façon, Nvidia peut non seulement fournir les GPU qui entraînent et exécutent les LLM, mais également fournir le logiciel qui permet aux modèles de s’exécuter et de fonctionner plus rapidement afin que les utilisateurs ne cherchent pas d’autres moyens de rendre l’IA générative rentable. La société a déclaré que TensorRT-LLM serait « accessible publiquement à toute personne souhaitant l’utiliser ou l’intégrer » et pourra accéder au SDK sur son site web.

Nvidia détient déjà un quasi-monopole sur les puces puissantes qui entraînent des LLM comme GPT-4 – et pour en former et en exécuter un, vous avez généralement besoin de beaucoup de GPU. La demande a grimpé en flèche pour ses GPU H100 ; les prix estimés ont atteint 40 000 $ par puce. La société a annoncé une version plus récente de son GPU, le GH200, qui arrivera l’année prochaine. Il n’est pas étonnant que les revenus de Nvidia aient atteint 13,5 milliards de dollars au deuxième trimestre.

Mais le monde de l’IA générative évolue rapidement et de nouvelles méthodes permettant d’exécuter des LLM sans avoir besoin de nombreux GPU coûteux sont apparues. Des sociétés comme Microsoft et AMD ont annoncé qu’elles fabriqueraient leurs propres puces pour réduire leur dépendance à l’égard de Nvidia.

Et les entreprises ont jeté leur dévolu sur l’aspect inférence du développement de l’IA. AMD prévoit d’acheter la société de logiciels Nod.ai pour aider les LLM à fonctionner spécifiquement sur des puces AMD, tandis que des sociétés comme SambaNova proposent déjà des services qui facilitent également l’exécution de modèles.

Nvidia, pour l’instant, reste le leader matériel en matière d’IA générative, mais il semble déjà se tourner vers un avenir où les gens n’auront plus à dépendre de l’achat d’un grand nombre de ses GPU.

Voici quelques-unes des principales conclusions de l’annonce de Nvidia :

- Nvidia ajoute la prise en charge de TensorRT-LLM à Windows et à des modèles tels que Stable Diffusion.

- TensorRT-LLM accélère l’inférence des LLM, ce qui les rend plus rapides et plus faciles à utiliser.

- Nvidia prévoit de rendre TensorRT-LLM accessible au public.

- Nvidia est confronté à une concurrence croissante dans le domaine de l’IA générative.

Que pensez-vous de l’annonce de Nvidia ?

Source : The Verge

Laisser un commentaire